做网站这么多年,我见过太多新手站长对 robots.txt 一知半解,要么写得太复杂,要么直接照搬别人的模板,结果不是屏蔽错页面,就是放行了大量无意义目录,最后导致收录变慢、重复页面变多,还浪费了抓取预算。

robots.txt 的目的并不是直接提升排名,而是让搜索引擎少走弯路,把抓取预算集中在有价值的页面上。对于像我这样长期更新 SEO、建站教程、独立站赚钱技巧的网站来说,抓取效率往往比什么都重要。

这篇文章主要解决三个问题:

- robots.txt 到底是什么?

- 网站 robots 的作用有哪些?

- robots 的基本写法应该怎么写?

最后我也会分享我目前在 锋哥富盟(fenggefu.com) 在线使用的 robots.txt 配置,供你参考。

robots.txt 是什么?

简单讲,robots.txt 是放在网站根目录下的一个纯文本文件,它的作用就是告诉搜索引擎:

- 哪些页面能抓

- 哪些页面不能抓

- 网站地图在哪里

robots 不直接决定排名,但它能决定“搜索引擎看到的是什么内容”,这对整个网站的抓取质量影响非常大。

配置正确的 robots 能让搜索引擎更快、更稳定地抓重要页面;配置不当则可能导致:

- 该收录的不收录

- 不该收录的一堆重复页反而被抓走

- 抓取预算大量浪费在无意义目录

robots.txt 的作用(站长必须知道的核心点)

虽然 robots.txt 不会直接提升排名,但它可以极大影响搜索引擎对网站的抓取方式。我总结为以下几个关键作用:

控制搜索引擎抓取范围

通过 Disallow 可以直接屏蔽后台目录、系统目录、搜索结果页等,让搜索引擎把更多精力放在文章页。

避免重复内容收录

tag、author、search 都属于重复内容来源,开放收录只会拖垮整站的内容质量。

提升抓取效率

让蜘蛛花更多时间抓你的“核心内容”,而不是插件目录、主题目录、缓存目录、日志文件。

隐藏敏感或低价值文件

像 /xmlrpc.php、/wp-login.php 这类文件不适合被抓取,屏蔽掉可以减少无效访问。

告诉搜索引擎网站地图位置

Sitemap 是提高抓取速度的关键入口,通过 robots 指明 sitemap 可以让蜘蛛更快发现内容。

robots.txt 的基本写法(新手掌握这些就够了)

robots.txt 虽然看起来神秘,但真正常用的语法就下面几个:

User-agent

表示“给谁生效”。例如:

User-agent: *意思是:对所有搜索引擎生效。

Allow

允许抓取的路径,例如 WordPress 中最重要的:

Allow: /wp-content/uploads/Disallow

禁止抓取某个目录或URL,而 robots 的主要工作就是写 Disallow。

Sitemap

用于声明网站地图的位置,例如:

Sitemap: https://www.fenggefu.com/sitemap.xml掌握这四个,你已经能写出 80% 网站都适配的 robots.txt。

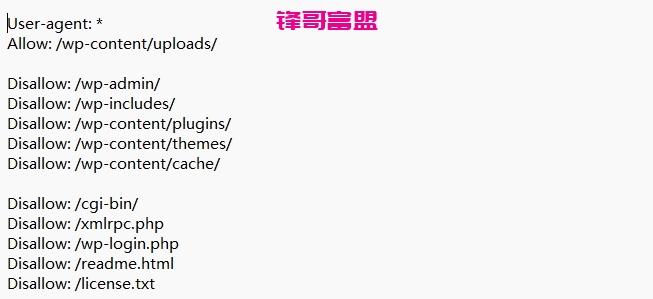

锋哥富盟正在使用的 robots.txt(实战示例)

下面这份就是我目前在 fenggefu.com 使用的正式 robots.txt,也是结合 WordPress 大学主题、缓存插件、图片优化插件、防垃圾插件之后的实际配置:

User-agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-content/cache/

Disallow: /cgi-bin/

Disallow: /xmlrpc.php

Disallow: /wp-login.php

Disallow: /readme.html

Disallow: /license.txt

Disallow: /search/

Disallow: /?s=

Disallow: /tag/

Disallow: /author/

Disallow: /*?utm_*

Disallow: /*?ref=*

Disallow: /*?from=*

Disallow: /*?page_id=*

Sitemap: https://www.fenggefu.com/sitemap.xml

这份 robots 为什么要这样写?(实战经验总结)

uploads 必须放行

uploads 是文章图片所在目录,禁止它会导致图片全部无法抓取,页面质量直接下降。

插件和主题目录无需抓取

其中大多数 JS、CSS、字体文件无 SEO 价值,反而浪费蜘蛛抓取资源,所以统一禁掉即可。

后台与系统目录要禁止

这些目录包含大量系统文件,抓取无意义,也可能暴露敏感路径,后台和系统文件统一屏蔽。

tag / author / search 不适合收录

这三类页面重复度极高,开放只会拖垮网站整体质量,建议所有内容站都屏蔽。

禁止常见参数,避免重复URL泛滥

utm、ref 等跟踪参数会制造大量页面副本,必须在 robots 中禁止。

缓存目录不需要搜索引擎抓取

缓存插件生成的内容不是正式页面,让蜘蛛抓缓存是纯浪费。

常见 robots 错误(很多新手都会踩)

- 抄“万能 robots”,结果屏蔽错目录

- 误屏蔽 /wp-content/ 导致图片无法抓取

- 放行 tag、author,导致大量重复内容收录

- 参数页面不处理,出现几十个重复版本

- 忘记写 Sitemap,抓取效率非常低

总结:内容站的 robots 应该怎么写?

- 只放行 uploads,其余目录全部禁止

- 后台、系统目录必须禁止

- tag/author/search 是重复内容源头,建议屏蔽

- 常见参数必须限制,避免重复页面

- 缓存目录不抓取,节省预算

- Sitemap 必须声明

以上就是我目前在线使用、并验证过的 robots.txt 思路,如果你的网站类型也偏向内容、教程、评测,这套配置可以直接套用,也可以根据自己的结构微调。

发表评论